深度学习的loss一般收敛到多少? - 知乎

看题主的意思,应该是想问,如果用训练过程当中的loss值作为衡量深度学习模型性能的指标的话,当这个指标下降到多少时才能说明模型达到了一个较好的性能,也就是将loss作为一 …

深度学习中loss和accuracy的关系? - 知乎

loss 的具体形式取决于机器学习任务的类型。 例如,在回归问题中,常用的 loss 函数包括平方损失、绝对损失和对数损失;在分类问题中,常用的 loss 函数包括交叉熵损失和 Hinge 损失。

keras深度学习框架输出acc/loss,val_acc/val_loss,什么意思?

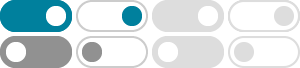

上图就是一个很典型的过拟合现象,训练集的 loss 已经降到0了,但是验证集的 loss 一直在上升,因此这不是一个很好的模型,因为它太过拟合了。 如果我们非要用这个模型,应该在5~10 …

深度学习的多个loss如何平衡? - 知乎

多个loss引入pareto优化理论,基本都可以涨点的。 例子: Multi-Task Learning as Multi-Objective Optimization 可以写一个通用的class用来优化一个多loss的损失函数,套进任何方法里都基本会 …

深度学习当中train loss和valid loss之间的关系? - 知乎

Nov 8, 2018 · 深度学习当中train loss和valid loss之间的关系,在一个caption实验当中,使用交叉熵作为损失函数,虽然随着训练,模型的评价指标的… 显示全部 关注者 35 被浏览

如何分析kaiming新提出的dispersive loss,对扩散模型和aigc会带 …

Dispersive Loss 的目的: 是最大化表示的 分散性。 当不进行 \ell_2 归一化时,特征向量的 范数(长度) 是被允许自由变化的。 如果模型为了最小化 Dispersive Loss,它会倾向于让特征向 …

神经网络模型train_loss下降,val_loss一直上升是什么原因? - 知乎

train_loss 不断下降, test_loss 不断上升,和第2种情况类似说明网络过拟合了。 应对神经网络过拟合的方法包括: 简化模型。 通过减少神经网络层数或神经元数量来降低模型复杂度,从而 …

强化学习中actor_loss和critic_loss收敛问题? - 知乎

在正常的训练过程中,actor_loss和critic_loss的减小趋势表明模型在不断学习和优化。 若在训练过程中发现actor_loss持续增大,这可能意味着Actor未能有效学习到优化策略,或者Critic的反馈 …

求通俗易懂解释下nce loss? - 知乎

Tensorflow实现了两种常用与word2vec的loss,sampled softmax和NCE,这两种loss本身可以用于任意分类问题。 之前一直不太懂这两种方法,感觉高深莫测,正好最近搞懂了,借tensorflow …

关于短语at a loss的用法? - 知乎

牛津高阶上,给出的用法是be at a loss for words 和I'm at a loss what to do next. (后例也出现在…